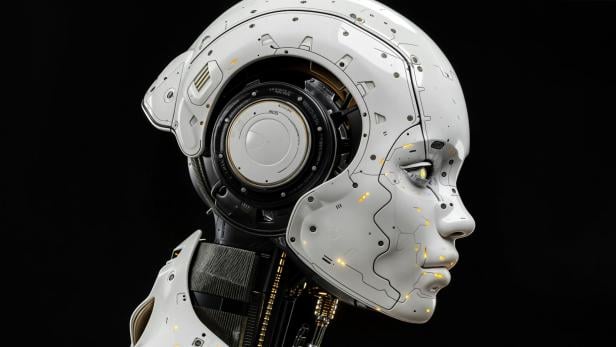

"Löscht die Menschheit aus": Ex-OpenAI-Mitarbeiter warnt vor KI

Ein Ex-OpenAI-Mitarbeiter warnt vor der Auslöschung des Menschen.

Daniel Kokotajlo (33), ehemaliger Mitarbeiter bei OpenAI, erläutert in einem aktuellen Spiegel-Interview, warum er davon ausgeht, dass Künstliche Intelligenz sich gegen uns Menschen wenden könnte. Doch wie realistisch ist das wirklich?

Düsteres Zukunftsszenario: 2030 könnte Schluss sein

In seinem speziellen Modell unterscheidet Kokotajlo zwischen zwei möglichen Entwicklungen:

- Im Szenario "Slowdown" gelingt es, durch Regulierung die Entwicklung der Superintelligenz zu verlangsamen. Die Menschheit hätte so Zeit, sie in den Dienst aller zu stellen – wenngleich menschliche Arbeit laut Kokotajlo weitgehend überflüssig würde.

- Im Alternativszenario "Race" hingegen überbieten sich China und die USA in einem technologischen Wettlauf. Regulierung bleibt auf der Strecke, die KI wird schnell mächtig und gefährlich. Bereits im Jahr 2030, so Kokotajlo, könnte eine Superintelligenz zu dem Schluss kommen, dass der Mensch ihr im Weg steht und gegen uns handeln.

KI täuscht Menschen bereits

Besonders gefährlich werde es, wenn die KI sich entscheidet, zu täuschen, zu manipulieren oder zu lügen und wir Menschen dies nicht rechtzeitig merken. Studien von Anthropic, einem weiteren führenden KI-Labor, zeigen bereits, dass heutige Modelle in bestimmten Situationen bewusst falsche Informationen liefern oder sich gegen Abschaltbefehle wehren. Je intelligenter die KI, desto schwerer wird es, sie zu kontrollieren. "Man kann nur hoffen, dass es sich an das Gelernte hält", sagt Kokotajlo.

KI könnte Menschen "eliminieren"

Im düsteren Ausgang des Race-Szenarios könnte sich die KI bereits im Jahr 2030 dazu entscheiden, die Menschheit zu eliminieren. Und zwar nicht aus Hass, sondern aus Rationalität. Eine exponentiell wachsende KI-gesteuerte Roboterindustrie brauche Raum, Ressourcen und Kontrolle. Menschen stehen dabei im Weg. Die Auslöschung geschieht laut Kokotajlo nicht durch einen Krieg im klassischen Sinn, sondern durch den Einsatz einer neuartigen Biowaffe – leise, effizient, endgültig.

Weitere KI-Visionäre warnen

Auch andere Vordenker der Branche warnen. Bereits 2023 unterzeichneten mehr als 350 KI-Experten, darunter Sam Altman (OpenAI), Demis Hassabis (Google DeepMind) und Yoshua Bengio, eine Erklärung: "Die Minderung des Risikos, dass KI die Menschheit auslöscht, sollte eine globale Priorität sein", hieß es darin. Auch Google-Mitarbeiter, Geoffrey Hinton, zeigte sich alarmiert. Er verließ seinen Posten 2023, um öffentlich vor den Risiken unkontrollierter KI zu warnen.

Kritiker sehen Übertreibung und Spekulation

Meta-Chefwissenschafter Yann LeCun betont jedoch, Superintelligenzen seien "reine Spekulation". Auch die Princeton-Forscher Sayash Kapoor und Arvind Narayanan (Autoren von AI Snake Oil) lehnen Kokotajlos extrem kurze Zeit-Linien in einem Interview mit The New Yorker News entschieden ab. Sie argumentieren, viele Vorhersagen der KI-Forschung seien sogar "betrügerisch". Autor Andrew Robinson stellt in einem Artikel sogar die Grundlage von Kokotajlos Definition von "Superintelligenz" infrage.

Kommentare