Von wegen objektive Wissenschaft: Idente Daten – variable Ergebnisse

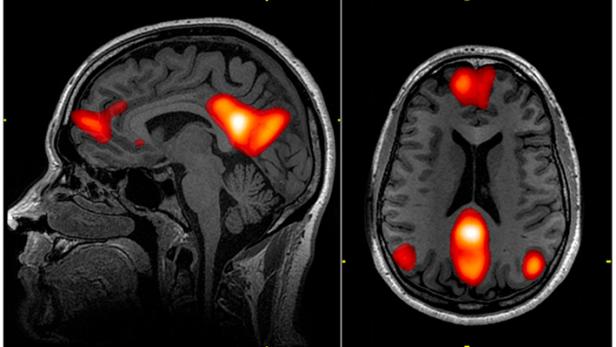

Die Analyse von Gehirnscans brachte unterschiedliche Ergebnisse.

Was passiert, wenn 70 Forschungsteams aus aller Welt unabhängig voneinander denselben Datensatz analysieren, um dieselben Hypothesen zu prüfen? Diese Frage beantwortet erstmals eine internationale Studie, die von den Ökonomen Michael Kirchler, Jürgen Huber und Felix Holzmeister vom Institut für Banken und Finanzen der Universität Innsbruck mitinitiiert wurde.

Gemeinsam mit Forschern des California Institute of Technology, der Stanford University, der Stockholm School of Economics und der Universität Tel Aviv haben sie etwa 200 Wissenschafter eingeladen, den selben MRT-Datensatz zu analysieren und neun Forschungshypothesen zu überprüfen.

108 Versuchskaninchen

Die Daten stammen aus einem Experiment in Tel Aviv, bei dem die Hirntätigkeit von 108 Probanden mit Hilfe von Funktioneller Magnetresonanztomographie aufgezeichnet wurde, während sie ökonomische Entscheidungen trafen. Das Verfahren zeigt mit hoher räumlicher Auflösung jene Hirnareale an, die während der Messung aktiv sind.

Eine Gruppe international führender Ökonomen und Behavioral-Finance-Experten lieferte den ersten Anstoß für das Projekt und leitete den Prognosemarkt-Teil. Prognosemärkte sind ein innovatives Instrument, mit dem überprüft werden soll, ob Experten in der Lage sind, die Ergebnisse eines Forschungsprojektes vorherzusagen – in diesem Fall, welche der neun getesteten wissenschaftlichen Hypothesen bestätigt werden.

70 Teams

Dieser Datensatz wurde an 70 Analyseteams aus der ganzen Welt verteilt. Aus Österreich beteiligt war die Universität Wien mit den Neuropsychologen Claus Lamm, Lei Zhang und Annabel Loosecat Vermeer; sowie die Mit-Initiatoren des Projektes um die Behavioral Finance-Gruppe von Michael Kirchler von der Universität Innsbruck.

Die neurowissenschaftlichen Forschungsteams wurden gebeten, diese Daten mit ihren etablierten Analyseverfahren dahingehend zu untersuchen, ob es Hinweise für einen Zusammenhang zwischen der Aktivität von Teilen des Gehirns und bestimmten Aspekten ökonomischer Entscheidungssituationen gibt.

Alle Forschungsteams hatten drei Monate Zeit, um die Daten zu analysieren und den Studienautoren ihre Ergebnisse sowie detaillierte Informationen über ihre Methoden zukommen zu lassen. Für fünf der Hypothesen wichen die Schlussfolgerungen der Teams erheblich voneinander ab, für die restlichen vier herrschte tendenziell Übereinstimmung.

„Interessanterweise zeigen die den Analysen zugrunde liegenden von den Teams aufbereiteten Datensätze noch eine relativ große Übereinstimmung zwischen allen Teams“, sag Felix Holzmeister. „Die ähnlichen Zwischenergebnisse führten aber am Ende zu zum Teil sehr unterschiedlichen Resultaten.“

Felix Holzmeister vom Institut für Banken und Finanzen der Universität Innsbruck

Eine Metaanalyse auf Basis der Zwischenergebnisse der verschiedenen Teams erbrachte hingegen ein einheitlicheres Bild. Dabei ließ sich zeigen, dass manche Aspekte der Datenanalyse einen gewichtigeren Einfluss auf das Ergebnis haben als andere, und eher zu positiven Ergebnissen führen. „Hier deuten sich bereits Wege an, wie der Forschungsprozess in solch komplexen Fragestellungen weiter verbessert werden kann: Forschungsprozesse sollten möglichst transparent gehalten und Daten und Methoden gemeinsam geteilt werden“, betont Michael Kirchler.

Kollege Jürgen Huber ergänzt: „Diese internationale Studie unterstreicht auch, wie wichtig es ist, dass wir Wissenschafter uns dieser möglichen Diskrepanzen bei komplexen Fragestellungen immer bewusst sind.“

Die Wissenschafter erhielten Geld, das sie auf unterschiedliche Resultate zu den untersuchten Thesen setzen konnten. „Dabei zeigte sich, dass die Marktteilnehmer überoptimistisch hinsichtlich der Wahrscheinlichkeit von signifikanten Ergebnissen waren, selbst dann, wenn sie die Daten zuvor selbst analysiert haben“, sagt Felix Holzmeister.

Fehlerkultur

„Die Tatsache, dass hier fast 200 Forscher bereit waren, Dutzende von Stunden in eine solche kritische Selbstüberprüfung zu investieren, unterstreicht die große Bereitschaft der Wissenschafter in diesem Gebiet, die Qualität ihrer Datenanalysen weiter zu verbessern. Dieser Prozess der Selbstreflexion und der kontinuierlichen Verbesserung der eigenen Methoden ist einzigartig und zeichnet die Wissenschaft aus“, betonen Michael Kirchler und Jürgen Huber.

Die Studie NARPS (Neuroimaging Analysis, Replication and Prediction Study) wurde in der Fachzeitschrift Nature publiziert.

Kommentare