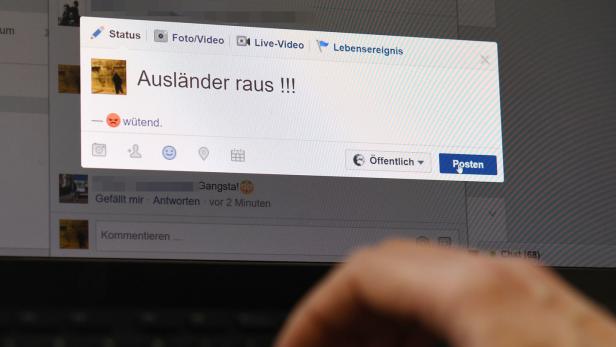

Hass im Netz: Neues Gesetz geht Experten zu weit

Türkis und Grün wollen gegen Hass im Netz vorgehen.

Sie will „Internetgiganten in die Knie zwingen“. Hasserfüllte, beleidigende und rechtswidrige Kommentare sollten „ganz schnell weg“.

Bravo, könnte man zum Vorhaben von Kanzleramtsministerin Karoline Edtstadler sagen. Bravo, dass eine Regierung das Thema „Hass im Netz“ an der Wurzel packt, die Plattformen in die Verantwortung nehmen will.

Statt „Bravo“ schlägt der ÖVP-Ministerin aber viel Skepsis entgegen. Experte Thomas Lohninger von epicenter.works sagt etwa, der Gesetzesentwurf sei „übers Knie gebrochen“ und werde dem komplexen Thema nicht gerecht. Im schlimmsten Fall würde nicht Facebook, sondern die Meinungsfreiheit im Netz „in die Knie gezwungen“.

Und er warnt: Bleibt das Gesetz so, wie es jetzt konzipiert ist, werden die Datenschützer vor den Verfassungsgerichtshof ziehen.

Binnen 24 Stunden

Was ist konkret geplant? Kanzleramtsministerin Edtstadler (ÖVP) und Justizministerin Alma Zadić (Grüne) wollen kommende Woche ein Gesetzespaket gegen „Hass und Gewalt im Netz“ in Begutachtung schicken. Während Zadić bei den strafrechtlichen Bestimmungen nachschärfen und den Rechtsweg erleichtern will, widmet sich Edtstadler den Plattformen.

So soll etwa Facebook einen Zustellbevollmächtigten nennen, der Postings, die gemeldet werden und „eindeutig rechtswidrig“ sind, binnen 24 Stunden löscht. Schwierigere Fälle binnen einer Woche.

Welche Plattformen das noch betrifft, soll von der User-Zahl abhängen. Darunter dürften auch Leser-Foren von Zeitungen fallen. Online-Enzyklopädien wie Wikipedia sollen explizit ausgenommen werden. Das war ein Kritikpunkt von Datenschützern, dem das Kanzleramt bereits entgegengekommen ist. Offen ist aber ein ganz wesentlicher zweiter Punkt – und da wären wir wieder bei der Meinungsfreiheit.

"Wie ernst nehmen wir unseren Rechtsstaat?"

Die Vorgabe, dass Postings sofort gelöscht werden müssen, wirft bei epicenter.works-Experte Lohninger die Frage auf: „Wie ernst nehmen wir unseren Rechtsstaat? Entscheiden wir oder ein globales Unternehmen, was rechtswidrig ist?“ Er befürchtet, dass Plattformen wie Facebook „den billigen Weg nehmen“, und Postings voreilig löschen, um sich Ärger zu ersparen.

Epicenter.works plädiert für einen „ausbalancierten Weg“. So soll der genannte Zustellbevollmächtigte jedenfalls in Österreich ansässig und kulturell verankert sein, um abwägen zu können, wann etwas tatsächlich eine Grenze überschreitet oder nur eine politisch abweichende Meinung, Satire oder – salopp formuliert – ein derber Schmäh ist.

Gang zum Höchstgericht

Zweitens fordern die Experten Transparenz ein: Die Plattformen sollen einen Bericht vorlegen, wie viele Meldungen von problematischen Postings sie erhalten haben und welche dann aus welchen Gründen gelöscht wurden. Zusätzlich sollen sich die Verfasser gerichtlich wehren können, wenn sie den Eindruck haben, ihr Posting wurde ungerechtfertigt gelöscht.

Aus dem Kanzleramt heißt es, dass die Verfasser über die Löschung benachrichtig werden und sie anfechten können – aber erst im Nachhinein.

Lohninger fehlt der „Anreiz“ für Plattformen, von vornherein sorgfältig zu moderieren. Deshalb schlägt er ein Bußgeld vor, sollte die gerichtliche Entscheidung von jener der Plattform abweichen. „Was nicht geht, ist, einfach zu löschen, damit man das Problem los ist“, betont er. Genau diese Praxis war nämlich der Grund, warum eine ähnliche Regelung in Frankreich vom Verfassungsgerichtshof gekippt worden ist. In Deutschland, wo es seit 2017 ein „Netzwerkdurchsetzungsgesetz“ nach ähnlichem Schema gibt, wurde schon zwei Mal nachgebessert.

Lohninger sagt, Österreich müsse aus diesen Erfahrungen lernen, sonst wird das neue Gesetz auch hierzulande nicht halten. Epicenter.works behält sich den Gang zum Höchstgericht vor.

Facebook bekommt Hass nicht in den Griff

Der nachlässige Umgang mit Hassreden bringt Facebook unter Druck: Mehr als 90 Firmen, darunter VW und Disney, strafen die Plattform derzeit mit einem Werbeboykott ab. Das kostet Facebook Milliarden an Einnahmen. Das Unternehmen räumt ein, nicht „perfekt“ zu sein, versuche aber kontinuierlich sich zu verbessern.

Auf Facebook und Instagram, das ebenfalls zum Facebook-Konzern gehört, können anstößige Inhalte und Kommentare von Nutzern gemeldet werden. Dieser Inhalt wird von einem Mitarbeiter geprüft. Laut Facebook gibt es 15.000 Personen für diese Tätigkeit. Wurde der Inhalt geprüft, erhält man eine Benachrichtigung, ob der gemeldete Beitrag gelöscht wurde. Eine Begründung, warum ein Inhalt z. B. nicht gelöscht wurde, erhält man allerdings nicht. Es wird lediglich mitgeteilt, dass nicht gegen die Richtlinien verstoßen wurde.

Zusätzlich kommt künstliche Intelligenz zum Einsatz. Laut Facebook wurden 88,8 Prozent der 10 Millionen Inhalte, die im ersten Quartal 2020 gelöscht wurden, von dieser KI erkannt. Twitter undYouTube nutzen eine ähnlich Technik.

Vertrauen auf Nutzer

Beschimpfungen wie „du Schlampe“ und Morddrohungen sind ein eindeutiger Verstoß – ob sie auch gelöscht werden, kommt aber darauf an: Laut Facebook wird jeweils der Kontext der Inhalte einbezogen. In geschlossenen Facebook-Gruppen müssen deren Administratoren die Regeln durchsetzen. Weil das häufig nicht passiert, bleiben Inhalte wie Nazipropaganda und Morddrohungen oft jahrelang online, wie unlängst deutsche Reporter ausgewertet haben.

Kommentare