Im Netz der Manipulation: Wahlkampf im Internet

Am 28. Juli eröffnete Sebastian Kurz den Wahlkampf auf Social Media: „Von links und von rechts hagelt es fast täglich neue Untergriffe, Diffamierungen und Dreck aus der allertiefsten Schublade“, postete er auf Facebook.

Kurz beklagt in dem Posting viel, unter anderem die Unterstellung, in einem Kinderporno mitgespielt zu haben. Ein abstruser, unbelegter Vorwurf eines Bloggers, der nie einer breiten Öffentlichkeit bekannt geworden wären, hätte ihn nicht der Ex-Kanzler selbst vor den Vorhang geholt und mit seinen 803.000 Fans geteilt. Aber warum tat er das?

Zur Einordnung: Auf Twitter hat der Blogger exakt 49 Follower. Er glaubt auch, dass die Anschläge auf das World Trade Center in New York von Israelis in Sankt Johann im Pongau geplant wurde. Alles in allem ein Mitbürger, den man nicht allzu ernst nehmen sollte.

Tat Kurz aber. Mehr noch – er instrumentalisierte ihn, um seine zentrale Botschaft anzubringen: Es werde nichts unversucht gelassen, um „ihn und damit seinen Weg für dieses Land aufzuhalten“.

Es war eines der erfolgreichsten Postings der jüngeren Vergangenheit: 35.000 Interaktionen (Likes, Kommentare und Shares) generierte er damit – ein extrem hoher Wert.

Das Posting war in Folge auch der Austria Presse Agentur (APA) eine Meldung wert und fand so den Weg in viele Tageszeitungen. Mittlerweile ermittelt sogar der Verfassungsschutz. Die Strategie hinter dem Kurz-Posting: Sich gegen Kritik zu immunisieren. „Egal, was wer auch immer sagt oder behauptet, ich wähle Sie“, kommentiert ein Fan das Posting.

Dieser Tenor zieht sich durch viele Kommentare. Was damit bei vielen Usern hängen bleibt: Alles, was online steht, ist Teil einer Schmutzkübel-Kampagne.

Manche sprechen sogar von der digitalen Revolution der Meinungsbildung. Denn die suggerierte große Gefahr: Nirgendwo scheint Manipulation leichter zu funktionieren als hier - zwischen Likes, Kommentaren und Einheitsbrei-Blasen.

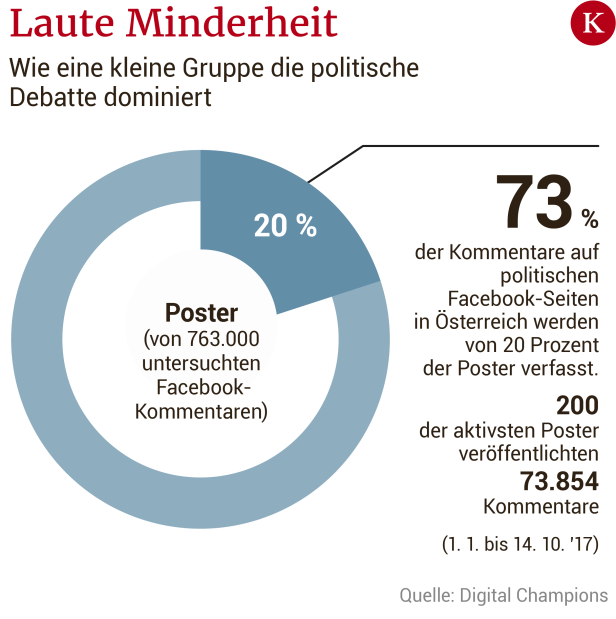

Manipulation heißt: Die Steuerung der Aufmerksamkeit der User, Bildung von Echokammern, der Einsatz von algorithmen-gesteuerten Social Bots, hyperaktive User und ihre Auswirkungen, Dark Posts, Fake News, Fake Accounts, Trolle und Troll-Fabriken.

Für viele Bürger sind Facebook & Co. längst zu einem Synonym für dreckigen Wahlkampf geworden. Wie groß ist die Gefahr der Meinungsmanipulation tatsächlich? Sollte die Öffentlichkeit jede dreiste Behauptung beachten? Und: Wählen Menschen aufgrund von Social Media anders?

Die Realität wird verzerrt

Facebook zählt heute fast zwei Milliarden Nutzer weltweit. Nicht alle sind echt. Für nur 100 Euro bekommt man 1.000 gefälschte Accounts, mit denen man mit wenig Aufwand durch Likes und Shares Aufmerksamkeit erzeugen kann.

Auch die klassischen Medien spielen keine unbedeutende Rolle, wie das Kurz-Beispiel zeigt. Postings, die auf Social Media große Aufmerksamkeit bekommen, wandern oft auch in die Zeitungen. Wenn diese Trends aber manipuliert wurden, wird die Realität weiter verzerrt.

Auch der Inhalt spielt eine große Rolle. „Wir wissen aus der Forschung, dass emotionalisierende Botschaften besonders oft geteilt werden. Das wissen aber natürlich auch Politik und Medien“, sagt Johannes Gründl, der am Institut für Staatswissenschaften an der Universität Wien zu den Themen politische Kommunikation und Social Media forscht.

Verkürzung, Zuspitzung und Emotionalisierung seien der Qualität von Debatten nicht immer zuträglich. Ein Problem seien populistische Kommunikationsstrategien, sagt Gründl:

„Diese vermitteln ein Bild, in der sich die einfachen Leute und die korrupten Eliten gegenüberstehen. Sie erzeugen eine klare Unterscheidung in Gut-Böse, erlauben ein Wir-Gefühl, emotionalisieren und erzeugen Wut. Entsprechende Postings ernten in der Regel viele Interaktionen.“

Einst waren die klassischen Medien die einzigen Gatekeeper in der politischen Debatte. An ihre Stelle treten nun im Netz vermehrt die großen Plattformen und deren Algorithmen. Diese seien aber nicht darauf optimiert, möglichst konstruktive politische Auseinandersetzung zu ermöglichen.

„Es geht darum, uns möglichst lange auf den Plattformen zu halten und uns dabei möglichst zielgenaue Werbung einzublenden.“

Werbung an 13-Jährige

Ein aktueller Werbe-Trend ist Mikrotargeting, mit dem man ganz gezielt kleine Bevölkerungsgruppen anspricht: Sebastian Kurz etwa bewirbt in einem Posting zu Fußball-TV-Rechten nur jene Menschen, die sich für die „UEFA Champions League“ interessieren, älter als 16 Jahre alt sind und in Österreich leben. Pamela Rendi-Wagner adressiert spezielle Postings an über 17-Jährige, Norbert Hofer bereits an 13-Jährige.

Das wäre an Schulen nie möglich: Laut Gesetz ist politische Werbung dort verboten. Auf Facebook allerdings können Werber penibel auswählen, wem welcher Inhalt angezeigt wird: Alter, Geschlecht, politische oder persönliche Vorlieben – es gibt kaum Grenzen.

Das ist vor allem dann problematisch, wenn die Öffentlichkeit nicht mehr überprüfen kann, an wen welche Botschaft versendet wird. Experten sprechen dann von „Dark Advertising“, also dunkler, geheimer Werbung.

„Es besteht dabei auch die Gefahr, dass widersprüchliche Botschaften beworben werden“, sagt die Digital-Expertin Ingrid Brodnig.

Gezieltes Ausspielen

So geschehen bei dem deutschen CDU-Politiker Jens Spahn: „Sichere Außengrenzen für ein sicheres Europa“ spielte er jenen Leuten aus, die sich für die AfD interessierten.

Jungen Großstädtern schickte er ein Foto mit fünf Jugendlichen verschiedener Ethnien, versehen mit dem Slogan „Deutschland ist großartig“. „Es war Glück, dass die Öffentlichkeit davon erfahren hat“, erklärt Brodnig.

Bis vor Kurzem gab es gar keine Möglichkeit, Manipulation durch Dark Advertising zu erkennen. Erst nach großen Kontroversen um den Trump-Wahlkampf und den Brexit reagierte Facebook und richtete eine „Werbebibliothek“ ein, in der politische Inserate dokumentiert werden.

„Das hat die Problematik leicht verbessert“, sagt Brodnig. Es gibt aber Hintertürchen: So wird bloß Werbung von Facebook-Seiten erfasst, die als „politisch“ kategorisiert wurden. Wenn die Parteien das nicht freiwillig tun, so prüft Facebook – nach eigenen Angaben – selbstständig. Darauf könne man sich allerdings nicht immer verlassen, sagt Brodnig.

Das FPÖ-nahe Portal „Unzensuriert“ sei zum Beispiel erst nach der EU-Wahl 2019 als politische Seite kategorisiert worden. Manipulative Werbeanzeigen von anonymen Facebook-Seiten wie „Die Wahrheit über Sebastian Kurz“ scheinen schlimmstenfalls nicht oder nicht zeitgerecht in der Werbebibliothek auf.

„Zudem ist nach wie vor nicht eruierbar, ob diese Anzeigen im Laufe der Zeit verändert werden“, sagt Barbara Wimmer, vom KURIER-Techportal futurezone. „Das ist technisch möglich und wird auch praktiziert“, kritisiert Wimmer.

Brodnig rät Facebook-Usern deshalb selbst herauszufinden, warum sie ins Netz von Werbern geraten. Mittels der drei Punkte neben einer Facebook-Werbeanzeige, “Warum sehe ich diese Werbung?“ gibt Facebook zumindest einige Informationen preis.

Wachsam sein

Wie manipulierbar sind wir also? „Den Einfluss auf die Wahlentscheidung kann ich wissenschaftlich nicht klar beziffern“, erklärt Gründl. „Wenn eine Information aber von jemandem aus meinem privaten Umfeld geteilt wird, neige ich eher dazu, mich damit auseinanderzusetzen.“

Vorsichtig sollten wir aber sein. Gibt es bei einem Blog ein Impressum? Berichten auch andere Medien darüber? Besondere Vorsicht gilt immer dann, wenn die Nachricht unsere politische Einstellung bestätigt. Die Forschung zeigt ganz klar, dass wir stark dazu tendieren, Fake News, die unsere Meinung bestätigen, eher zu glauben und auch zu teilen.

Seiten wie www.mimikama.at helfen, Fakes zu enttarnen. „Die vielen Manipulationsmöglichkeiten im Netz bremsten die Euphorie über das freie Internet“, so Gründl. Es entstand die Befürchtung, dass sich Menschen künftig nur noch in geschlossenen Echokammern informieren.

Dort würden User nur noch mit ihrer eigenen Weltsicht konfrontiert werden. „Diese Befürchtung hat sich wissenschaftlich aber nicht bestätigt“, sagt Gründl, „zumindest, was die Mehrheit der Bevölkerung betrifft.“

Grundsätzlich sei die politische Kultur hierzulande eine andere als in den USA, was etwa Negative und Dirty Campaigning betrifft. “Da solche Maßnahmen immer auch negativ auf den Urheber zurückfallen können, bestehen zum Beispiel in Mehrparteiensystemen grundsätzlich größere Hemmungen der Parteien – den Wählerinnen und Wählern stehen ja andere Parteien auch noch als Option zur Verfügung”, sagt Gründl.

„Die Wahl wird nicht im Internet gewonnen“, sagt auch Brodnig, man solle die Bedeutung nicht überschätzen. „Ein guter Online-Wahlkampf kann jedoch hilfreich sein, Menschen zu bewegen, zur Wahl zu gehen.“

Troll: Gibt in sozialen Netzwerken und Foren vor, er würde gern diskutieren. Hauptinteresse ist aber die Zerstörung der Diskussion. Dafür bedient er sich verschiedener Mittel (Ironie, blöde Nachfragen, Beleidigungen).

Fake Accounts: Gefälschter Account, mit dem jemand vorgibt, eine andere reale oder fiktive Person zu sein. Wird u. a. für Fake Posts verwendet.

Fake Posts: Gefälschte Postings, mit denen (politische) Unwahrheiten und Gerüchte verbreitet werden.

Bots: Programme, die das Verhalten von Usern nachahmen. Können verwendet werden, um Tausende Fake Accounts zu steuern.

Echokammer: Facebook & Co zeigen Inhalte nach einem Algorithmus, der berechnet, was einem gefallen könne. Dadurch erfährt man wenig Neues, wird aber in seiner Meinung bestärkt.

Negative Campaigning: Kampagne, bei der politische Gegner verunglimpft werden.

Dirty Campaigning: Negative Campaigning – mit „dreckigen“ Mitteln, etwa gezielt Gerüchte zu streuen.

Kommentare