Killerroboter: "Die perfekten Waffen für Terroristen"

Der südkoreanische Kampfroboter Samsung SGR-A1 steht an der Grenze zu Nordkorea.

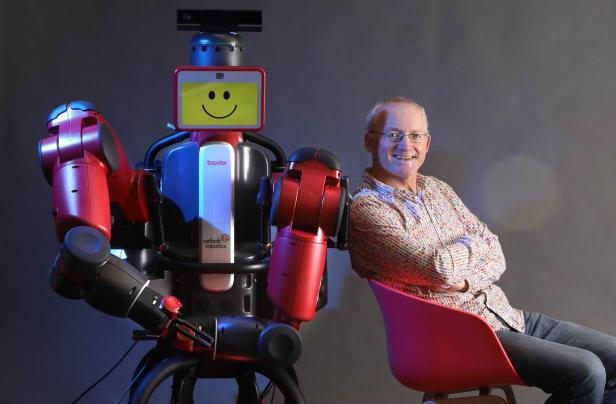

Toby Walsh wurde ungefähr zur selben Zeit geboren wie Sarah Connor aus dem Film Terminator. Und wie Sarah Connor kämpft auch er gegen "Killerroboter". 2015 war der australische Künstliche-Intelligenz-Forscher Mit-Initiator eines offenen Briefs, der zum Verbot von autonomen Waffensystemen aufrief; er wurde unter anderem vom kürzlich verstorbenen Physiker Stephen Hawking, Tesla-Gründer Elon Musk und Apple-Mitbegründer Steve Wozniak unterzeichnet.

Forscher Toby Walsh mit Roboter Baxter, der niemanden töten will.

KURIER: Sie treten seit Jahren für ein Verbot von autonomen Waffensystemen ein, die oft auch als Killerroboter bezeichnet werden. Warum halten Sie diese für so gefährlich?

Toby Walsh: Der vermutlich wichtigste Punkt ist: Es sind Massenvernichtungswaffen. Wenn man großen Schaden anrichten will, braucht man aktuell noch eine Armee. Ausgebildete Soldaten, die das tun, was man ihnen anschafft. Autonome Waffensysteme wären schneller und genauer als Menschen, sie könnten rund um die Uhr kämpfen.

Sie bezeichnen autonome Waffensysteme als als dritte Revolution in der Kriegsführung nach dem Schießpulver und Nuklearwaffen.

Ja, sie würden eine komplett neue Form der Kriegsführung bedeuten. Sie würden das Töten industrialisieren. Und sie werden viel leichter zu bekommen sein als Nuklearwaffen. Für ein autonomes Waffensystem braucht es einen Programmierer und einen 3D-Drucker, mehr nicht. Das macht sie gefährlicher als Nuklearwaffen.

Sie sind aktuell bei einem UN-Meeting in Genf mit dem Ziel, autonome Waffensysteme zu verbieten – bringt das überhaupt etwas, wenn sie so leicht herzustellen sein werden?

Es ist wichtig sich ins Gedächtnis zu rufen, dass alle anderen Massenvernichtungswaffen, ob chemische oder biologische, von den Vereinten Nationen verboten wurden. Deshalb bin ich zuversichtlich, dass das bei autonomen Waffensystemen auch passieren wird. Chemische Waffen sind vielleicht ein guter Vergleich, weil sie auch sehr einfach herzustellen sind. Manchmal werden sie leider eingesetzt, etwa in Syrien, aber die Welt ist vermutlich trotzdem ein besserer Ort, weil sie verboten sind.

Sie haben vergangene Woche zu einem Boykott gegen die renommierte südkoreanische Universität KAIST aufgerufen, weil sie mit einem südkoreanischen Waffenhersteller kooperieren will. Kommt es oft vor, dass Universitäten mit Waffenherstellern kooperieren?

Es war das erste Mal, dass das offen passiert ist. Noch dazu ist das ein berüchtigtes Unternehmen, das einen sehr schlechten Ruf hat – und das erklärte Ziel, autonome Waffen herzustellen. Die Universität hat aber sehr schnell reagiert und angekündigt, an keinen Waffensystemen mitzuarbeiten, die keine maßgebliche menschliche Kontrollmöglichkeit mehr haben. Das war ein sehr schneller Erfolg für uns und wir konnten den Boykott wieder aufheben.

Der überwiegende Anteil der Forschung an autonomen Waffensystemen passiert vermutlich im Geheimen – ist bekannt, welche Staaten an welchen Projekten forschen?

Das stimmt, und es findet ein Wettrüsten in dem Bereich statt. Die Staaten, die daran hauptsächlich forschen, sind wenig überraschend die USA, Russland, China, Großbritannien und Israel. Bis zu einem gewissen Grad auch Südkorea. Für jeden Bereich der Kriegsführung gibt es schon Prototypen autonomer Waffen, von denen wir wissen. Autonome Drohnen etwa. Die US-Navy hat mit dem „Sea Hunter“ ihr erstes autonomes Kriegsschiff. Russland hat einen autonomen Panzer, ein südkoreanischer autonomer Geschützturm ist an der Grenze zu Nordkorea sogar schon im Einsatz.

Wie müssen wir uns den Krieg der Zukunft vorstellen, wenn diese Killerroboter zum Einsatz kommen?

Wir würden uns nicht mehr verteidigen können. Menschen hätten keine Chance. Das sind schrecklich effektive Waffen. Es sind auch die perfekten Waffen für Terroristen: Einem Programm ist es egal, wie böse derjenige ist, der es einsetzt. Es exekutiert, wofür es programmiert ist. Es hat kein Gewissen und ist billig. Es ist also fast sicher, dass solche Waffen in die Hände von Terroristen gelangen und gegen Zivilisten eingesetzt würden. Es gibt die naive Idee, dass dann nur noch Roboter gegen Roboter kämpfen würden, das wäre natürlich nicht so.

Es wird aktuell viel über Ethik in selbstfahrenden Autos diskutiert, weil die ja – ein klassisches Beispiel – entscheiden müssen, wann und ob sie das Leben ihrer Fahrers opfern, etwa um einem Kind das Leben zu retten. Gibt es diese Diskussion auch bei autonomen Waffensystemen, dass sie ethische Richtlinien einprogrammiert bekommen?

Das ist ein spannendes Argument: Dass Roboter ethischer sein könnten als Menschen, wenn sie programmiert wären, keine Kriegsverbrechen zu begehen. Menschliche Soldaten verhalten sich in Extremsituationen, wenn ihr eigenes Leben auf dem Spiel steht, manchmal sehr grausam – das wäre bei Robotern anders, die haben keine Emotionen und keine Angst vor dem Tod. Aber es gibt zwei große Probleme: Erstens, wir können das aktuell nicht programmieren. Autonome Waffensystem können Soldaten derzeit nicht von Zivilisten unterscheiden. Und selbst wenn wir das irgendwann können, kommt das zweite Problem ins Spiel: Sie können gehackt werden.

Menschen, die vor autonomen Waffensystemen oder Künstlicher Intelligenz im Allgemeinen warnen, beklagen oft, dass sie nicht ernst genommen werden, weil das alles zu sehr nach Science Fiction klingt – passiert Ihnen das auch?

Wann immer ich interviewt werde, steht daneben ein Bild des Terminator. Der Terminator ist wirklich noch Science Fiction, diese Technologie ist noch mindestens fünfzig oder hundert Jahre weit weg. Mir macht eine viel dümmere Künstliche Intelligenz Sorgen. Die gibt es jetzt schon. Es gibt bereits autonome Drohnen. Die sind viel simpler und dümmer als der Terminator, aber trotzdem eine große Gefahr.

Künstliche Intelligenz an sich macht vielen Menschen sorgen. Es gibt das Gedankenexperiment, dass eine Künstliche Intelligenz, die dazu programmiert ist, Büroklammern herzustellen, die Menschheit auslöschen könnte, weil sie sich immer weiter selbst optimiert und immer mehr Ressourcen anhäuft, bis für den Menschen keine mehr übrig sind.

Man kann das nicht als Unsinn abtun, aber es macht mir keine großen Sorgen. Ich glaube, die existentielle Gefahr, die von Künstlicher Intelligenz ausgehen kann, liegt noch weit in der Zukunft. Aber die Wissenschaft steht immer wieder vor der Herausforderung, dass sie die Menschheit vernichten könnte. Vor dem ersten Nukleartest haben Wissenschaftler die Wahrscheinlichkeit ausgerechnet, dass sie damit die Atmosphäre verbrennen und den Planeten zerstören. Als der Hadron-Collider in Betrieb gesetzt wurde, gab es die Angst, dass dadurch kleine schwarze Löcher entstehen, die die Erde verschlucken. Aber derzeit sollten wir uns viel mehr um aktuelle Probleme sorgen – eben autonome Waffensysteme, den Klimawandel, Fundamentalismus und die steigende Ungleichheit in unseren Gesellschaften.

Kommentare